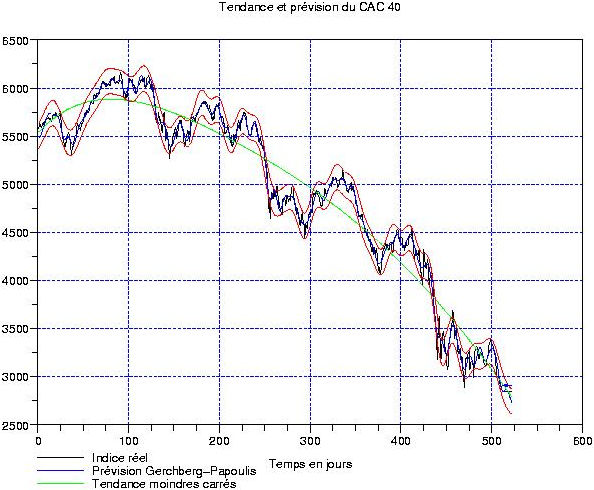

A la suite d’une discussion intéressante avec un lecteur, j’ai passé du temps ce week-end à étudier nos grands indices boursiers en partant d’un nouveau point de vue: à savoir qu’il devient chaque semaine plus important de « s’entrainer » à trouver la fin de la baisse. Et, pour ceux qui bidouillent du BX4 (que ce soit en trading ou en buy & hold) depuis les 6000 points, le plus gros du chemin est maintenant parcouru (meme si vu l’effet de levier maintenu constant, les gains dans les dernières semaines seront balèzes de chez balèzes, attention à ne pas etre trop gourmands!). Or, un bon moyen de trouver une amorce de retournement, c’est de systématiquement utiliser des tendances aux moindres carrés polynomiales de degré nettement plus élevé que le strict nécessaire. Concrètement, pour notre CAC 40 sur 2 ans, le strict minimum correspond au degré 2 (tendance convexe ou concave et rien d’autre), et celle que j’utiliserai dorénavant est un degré 5 (voir le graphique plus haut, courbe en vert).

A la suite d’une discussion intéressante avec un lecteur, j’ai passé du temps ce week-end à étudier nos grands indices boursiers en partant d’un nouveau point de vue: à savoir qu’il devient chaque semaine plus important de « s’entrainer » à trouver la fin de la baisse. Et, pour ceux qui bidouillent du BX4 (que ce soit en trading ou en buy & hold) depuis les 6000 points, le plus gros du chemin est maintenant parcouru (meme si vu l’effet de levier maintenu constant, les gains dans les dernières semaines seront balèzes de chez balèzes, attention à ne pas etre trop gourmands!). Or, un bon moyen de trouver une amorce de retournement, c’est de systématiquement utiliser des tendances aux moindres carrés polynomiales de degré nettement plus élevé que le strict nécessaire. Concrètement, pour notre CAC 40 sur 2 ans, le strict minimum correspond au degré 2 (tendance convexe ou concave et rien d’autre), et celle que j’utiliserai dorénavant est un degré 5 (voir le graphique plus haut, courbe en vert).

Voyons de suite un effet sur la transformation en ondelettes continues de la fluctuation restante (les cotations moins la tendance d’ordre 5): voir ci-contre. Outre le fait que la tendance ainsi trouvée descend un peu moins que celle de degré 2 (-13 points/jour contre -18 points/jour), elle permet de produire une fluctuation dont le spectre est beaucoup plus concentré autour d’un unique cycle sur la totalité de l’intervalle d’étude. Notamment, les rotations de période entre 100 et 150 jours (en gros 6 mois de cotations boursières) dominent incontestablement. Voir ici pour une comparaison.

Voyons de suite un effet sur la transformation en ondelettes continues de la fluctuation restante (les cotations moins la tendance d’ordre 5): voir ci-contre. Outre le fait que la tendance ainsi trouvée descend un peu moins que celle de degré 2 (-13 points/jour contre -18 points/jour), elle permet de produire une fluctuation dont le spectre est beaucoup plus concentré autour d’un unique cycle sur la totalité de l’intervalle d’étude. Notamment, les rotations de période entre 100 et 150 jours (en gros 6 mois de cotations boursières) dominent incontestablement. Voir ici pour une comparaison.

Observons maintenant (ci-contre, à droite) la fluctuation en UT jour. Son spectre numérique de Fourier est visible en haut à gauche; en le comparant avec celui obtenu avec une tendance quadratique, on observe (comme pour la transformation en ondelettes) qu’il est beaucoup plus ramassé autour du cycle à 120 jours. Nous voyons qu’après la glissade des 2 semaines précédentes, la fluctuation est maintenant revenue autour du niveau zéro. L’extrapolation numérique est donc pratiquement neutre (bas, gauche), ce qui signifie que l’évolution de l’indice dans les jours à venir devrait etre dominée par sa tendance de fond. On pourrait donc avoir une poursuite de la baisse, mais à une vitesse moindre que ces derniers jours …

Observons maintenant (ci-contre, à droite) la fluctuation en UT jour. Son spectre numérique de Fourier est visible en haut à gauche; en le comparant avec celui obtenu avec une tendance quadratique, on observe (comme pour la transformation en ondelettes) qu’il est beaucoup plus ramassé autour du cycle à 120 jours. Nous voyons qu’après la glissade des 2 semaines précédentes, la fluctuation est maintenant revenue autour du niveau zéro. L’extrapolation numérique est donc pratiquement neutre (bas, gauche), ce qui signifie que l’évolution de l’indice dans les jours à venir devrait etre dominée par sa tendance de fond. On pourrait donc avoir une poursuite de la baisse, mais à une vitesse moindre que ces derniers jours …

Finissons comme d’habitude avec le bruit de marché residuel; ci-contre en haut à gauche. La répartition probabiliste est à droite. On trouve que celle-ci est bien approchée par une gaussienne de memes moyenne et variances. L’écart-type est très simple: 50 points! Donc, 100 points en haut et en bas donnent en théorie une sécurité à 95% quant au risque que constituent les oscillations intra-day du CAC. Pour etre tranquille, on peut aller jusque 150 (ce qui en théorie donne 98%) …

Finissons comme d’habitude avec le bruit de marché residuel; ci-contre en haut à gauche. La répartition probabiliste est à droite. On trouve que celle-ci est bien approchée par une gaussienne de memes moyenne et variances. L’écart-type est très simple: 50 points! Donc, 100 points en haut et en bas donnent en théorie une sécurité à 95% quant au risque que constituent les oscillations intra-day du CAC. Pour etre tranquille, on peut aller jusque 150 (ce qui en théorie donne 98%) …

Conclusion: pour la semaine à venir, pronostic en légère baisse (moins soutenue que les 2 précédentes), peut-etre un doji ou une toupie en hebdomadaire. Ceux qui ont shorté il y a 3 semaines et qui n’ont pas pris de bénéfices sous les 2800 points gardent leurs positions. Dans le cas ou un évennement macro ferait repartir les indices plein sud rapidement, ces positions baissières devraient etre liquidées sous les 2600 points. Les efforts de développement, maintenant, doivent progressivement etre réassignés vers des techniques liées au dépistage des signes de retournement à venir …

Très intéressant. Pourquoi ne pas essayer avec un polynome de degré impair encore plus élevé?

Il n’y a pas besoin d’imposer que le degré soit impair. Le problème d’aller à des degrés très élevés est un peu technique: cela a trait à ce qu’on appelle l’incohérence des bases fonctionnelles. En gros, des bases sont incohérentes si les produits scalaires dans L2 de leurs vecteurs sont petits en modules. Si vous prenez des polynomes de degrés élevés, vous commencez à obtenir quelque chose qui ressemble diablement à une sinusoide, et donc la cohérence augmente ce qui fait que les bases polynomiales et sinusoidales commencent à devenir cohérentes (et donc REDONDANTES) entre elles; par exemple, les polynomes de Legendre http://fr.wikipedia.org/wiki/Fichier:Legendre_poly.svg

Donc, au bout d’un moment, augmenter le degré des polynomes dans la tendance revient peu ou prou à annuler des coefficients de Fourier de la fluctuation. Comme les extrapolations d’un polynome et d’un signal de Fourier sont différentes, cela revient à échanger la facon d’extrapoler d’une certaine portion du signal considéré.

Mon point de vue, c’est en gros de dire que lorsque l’erreur de detrending devient stationnaire pour des degrés inférieurs à 7 ou 8, on ne va pas plus loin pour ne pas rogner sur la partie « Fourier » du signal.